个人的所有学习笔记

基础知识

- 矩阵算法/高数知识

线性回归算法

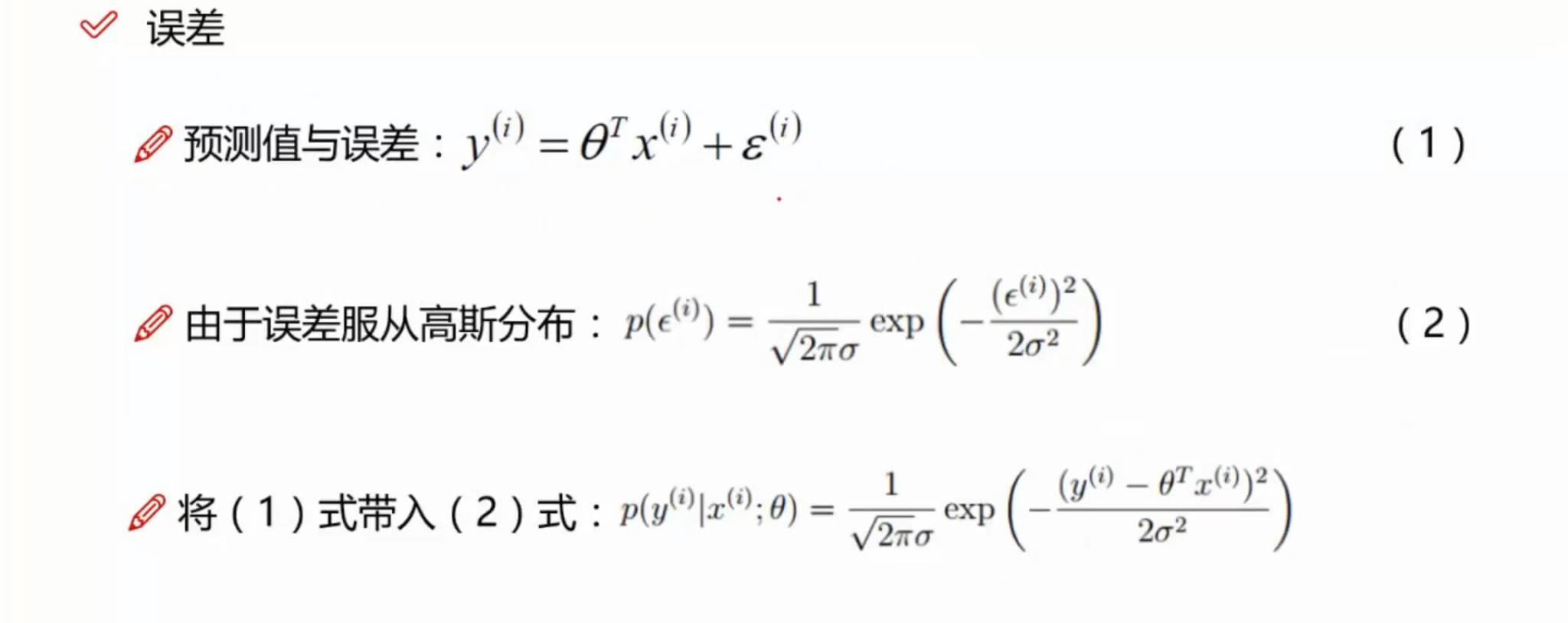

误差:真实值和实际值之间的误差

- 似然函数:由数据去推参数,什么样的参数跟我们的数据组合后恰好是真实值

- 对数似然:乘法难解,加法就容易了,对数里面的乘法可以转换为加法

评估方法

R^2 = xxxxxx

越接近1,拟合程度越高

梯度下降

-

引入

当我们得到了一个目标函数后,如何进行求解?直接求解?(并不一定可解,线性回归可以当作一个特里) -

常规套路

机器学习的套路就是我交给机器一堆数据,然后告诉它什么样的学习方式是对的(目标函数),然后让它朝着这个方向去做。 -

如何优化?

逐步完成迭代优化,每次优化一点点。

批量梯度下降

- 容易得到最优解,但是由于每次考虑所有样本,速度很慢

- 准确度最高

随机梯度下降

- 每次找一个样本,迭代速度快,但不一定每次都朝着收敛的方向

小批量梯度下降法

- 每次更新选择一小部分数据来算,实用!

学习率(步长)

- 对结果会产生巨大的影响,一般小一些

- 如何选择:从小(一般0.01)的时候,不行再小

- 批处理数量: 32,63,128都可以,很多时候还得考虑内存何效率

逻辑回归(Logistic regression)

- 目的:分类还是回归?是经典的二分类算法;

- 机器学习算法选择:先逻辑回归再用复杂的,能简单还是用简单的;

- 逻辑回归的决策边界:可以是非线性的

Sigmoid 函数

- 公式:

g(z) = 1 / (1 + e^(-z))

- 自变量取值为任意实数,值域[0,1]

- 解释:将任意的输入映射到了[0,1]区间,我们可以在线性回归中可以得到一个预测值,再将该值映射到Sigmoid函数中,这样就完成了由值到概率的转换,也就是分类任务

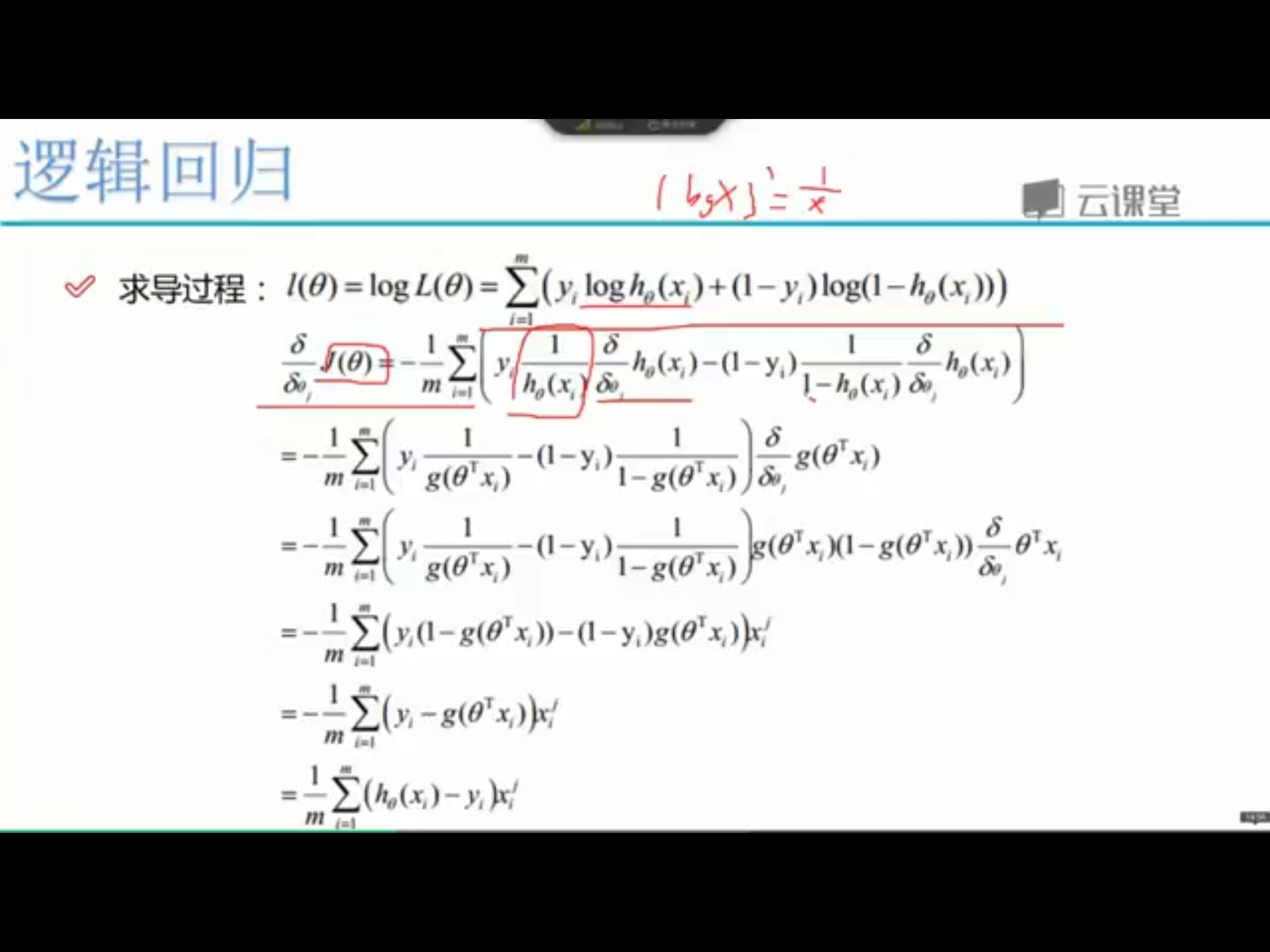

- 似然函数

- 对数似然

- 此时应用梯度上升求最大值,引入J(@) = – l(@) / m 转换为梯度下降任务

参数更新

多分类的softmax:

总结:Logistic regression is great !

图片说明

图片截取于网上的学习视频,如有侵权,请麻烦联系我!

Leave a Reply